llama3.1是ai界的linux?先部署起来再说! | learnku 产品论坛-大发黄金版app下载

点赞 关注 收藏 = 学会了

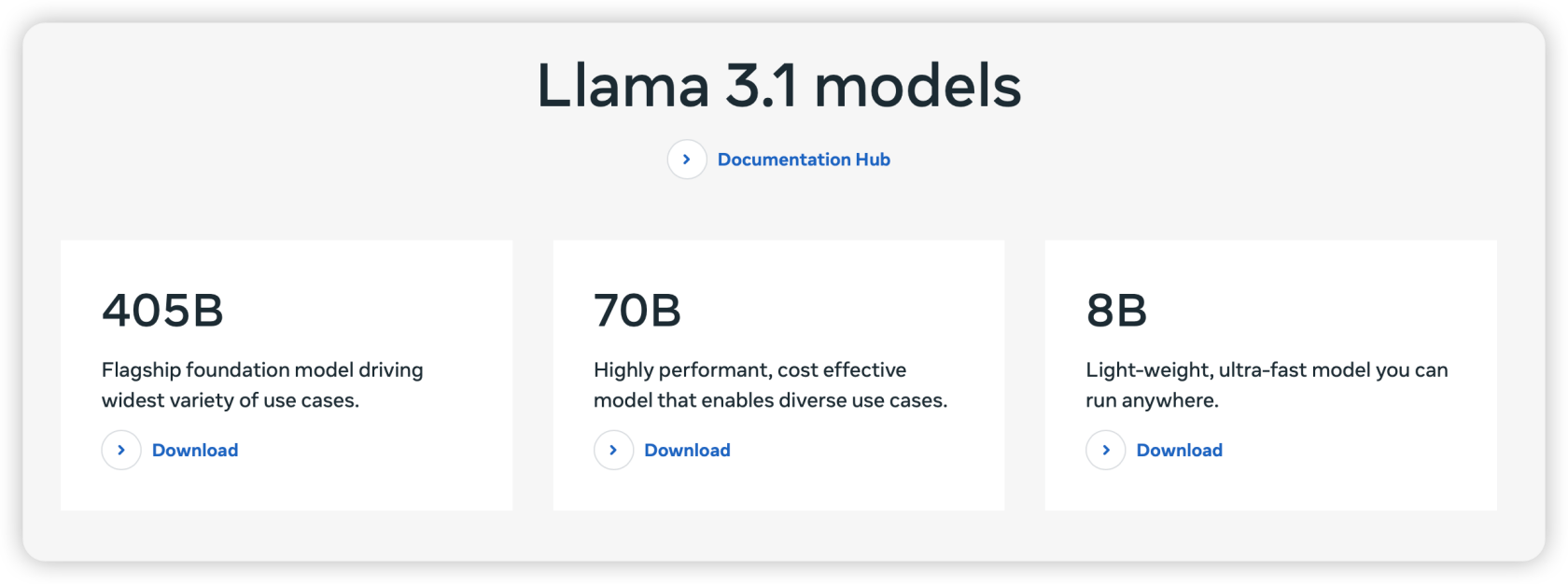

上周 meta 发布了 llama 3.1,这次带来的中杯、大杯和超大杯3个版本。

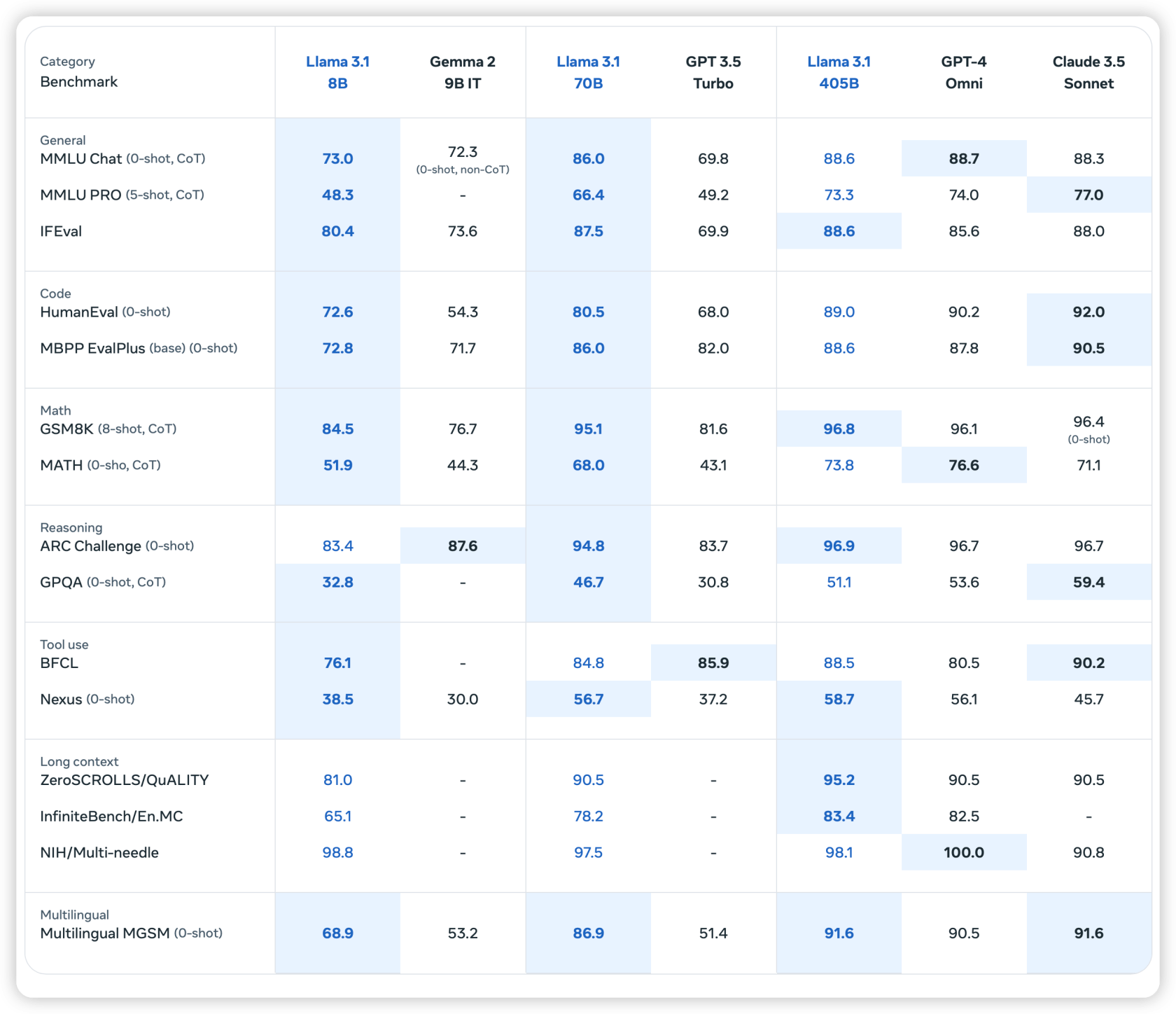

从纸面数据来看,llama 3.1 超大杯已经能跟 gpt-4 omni、claude 3.5 sonnet 分庭抗礼了。

而中杯和大杯更是将同量级的对手摁在地上摩擦。

要知道,llama 的对手可是闭源模型啊工友们!

小扎同志说,开源ai会成为行业的标准,就像linux一样!

不管怎么说,既然你开源了,那我就在本地部署起来吧。

本文使用 ollama 在本地运行大语言模型,它不止能运行 llama 3.1 ,还支持阿里的 qwen2 等开源模型。

同时借助 openwebui 的帮助,让你可以在图形化界面里跟 llama 3.1 聊天互动。

ollama 是一个专门为在本地环境中运行和管理大型语言模型(llm)而设计的开源工具。

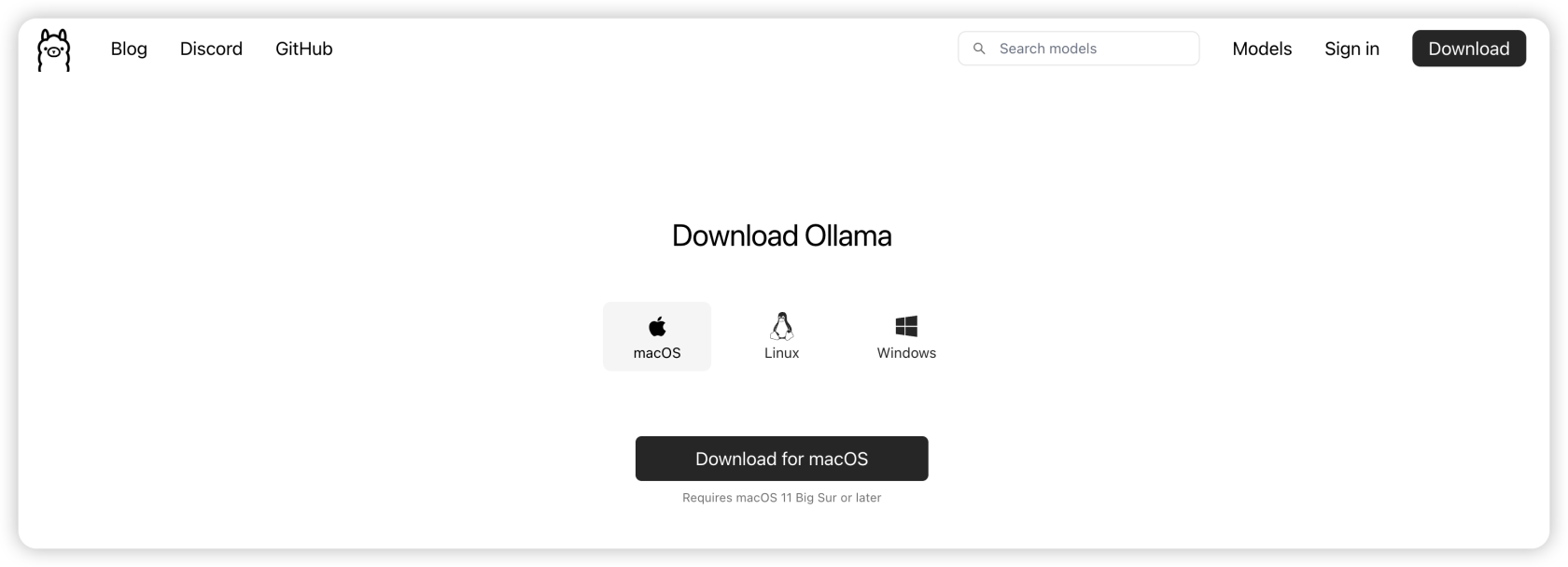

打开 下载 ollama。

根据你的系统去下载对应的安装包即可。下载完就运行它,傻瓜式安装,一直点“下一步”就行了。安装完你就能看到一个客户端的图标。

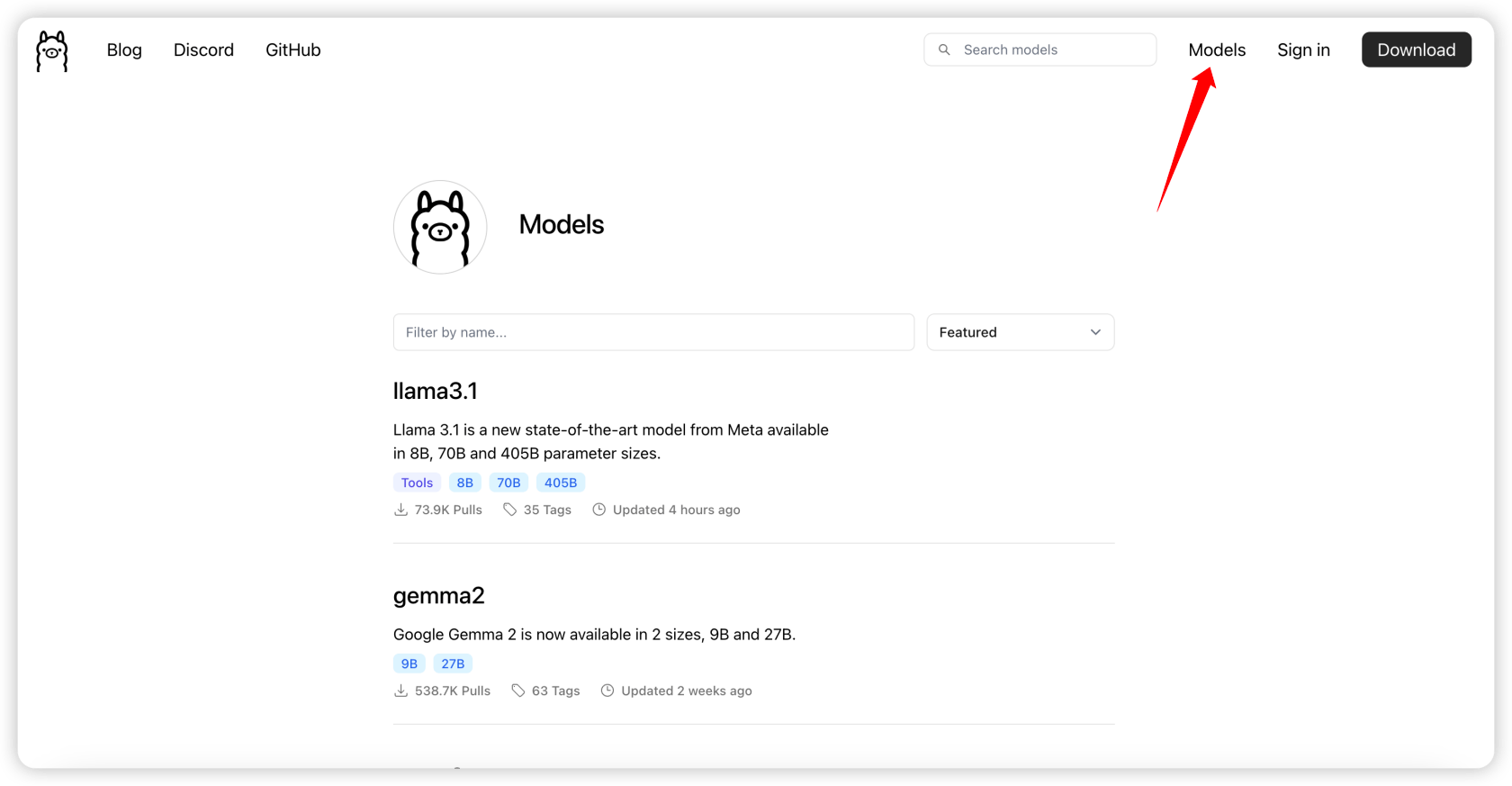

回到 ,进入 models 页面,这里会列出很多热门的模型。你也可以在搜索框里搜索自己想要的模型。

这里我们选择 llama3.1 。

蓝框可以选择不同量级的 llama 3.1 模型,红框是选中的这个模型的下载和运行命令。

405b的模型231个g,我电脑实在玩不起,硬盘的剩余空间都没这么大😭

我就拿8b的模型演示一下吧~

在终端输入这条命令就会开始下载 llama 3.1 8b的这个模型,如果已经下载过了它会直接运行,不需要重复下载。

ollama run llama3.1下载并运行成功后,你就可以在终端跟 llama 3.1 这个模型对话了。

当然啦,如果你觉得 llama 的中文不太强,可以试试阿里的 qwen2 ,在 搜 qwen2 选择指定版本,复制下载命令到终端执行即可。

在终端和大语言模型聊天实在太原始了,有套好看的 web 界面会更容易在老板面前装杯。

本文要介绍的是 ,使用 docker 运行它会比较方便。

看到 docker 不要慌,很简单的。

打开 ,根据你的系统下载对应版本的 docker 客户端。

接着继续傻瓜式安装即可。

安装完 docker 后,需要打开 docker 客户端。

接着我们打开 ,文档列出几种运行方式,如果在本地运行,复制红框的命令在终端运行即可。如果你电脑有n卡,可以用绿框那条命令。

执行完上面的命令后,在浏览器访问 http://localhost:3000/ 就能看到下面这个界面。

首次注册的用户是管理员账户,邮箱和密码都可以随便填,这些都是保存在你本地的数据。只要你记得自己注册的是什么邮箱和密码就行了。

登录后就能看到上面这个界面,在聊天窗上方选择 llama3.1 模型就可以开始愉快的聊天了。

以上就是本文的全部内容啦。下一篇打算介绍一下“如何在本地部署一个基于 llama 3.1 的 coze 平台” 😁

点赞 关注 收藏 = 学会了

本作品采用《cc 协议》,转载必须注明作者和本文链接

我要是上周看到你这个就好了。我捋清楚这些花了2天。哭了

这个可以训练吗? 机器配置呢?